Een nieuw algoritme laat zien dat robots in computersimulaties al na een enkele demonstratie taken kunnen leren.

Computerwetenschappers aan de University of Southern Califoria in Los Angeles hebben een nieuw online algoritme ontwikkeld, RoboClip, waarmee robots sneller kunnen leren in nieuwe omgevingen. De hoeveelheid data die nodig is om robots te trainen vermindert er dramatisch door. Iedereen krijgt nu de mogelijkheid met hen te communiceren via taal of video’s – althans, voorlopig, in computersimulaties. Vergrijzende bevolkingen en zorgverleners zullen het meeste profiteren van toekomstig werk op basis van RoboClip.

Snel leren

Voor de ontwikkelaars is het meest indrukwekkende aan RoboClip, dat ze hun robots iets kunnen laten doen op basis van slechts één videodemonstratie of één taalbeschrijving. De grote hoeveelheid data die momenteel nodig is om een robot de taak te laten uitvoeren die iemand wil, is niet haalbaar in de echte wereld, waar je robots wilt die snel kunnen leren met weinig demonstraties.

Om dit notoir moeilijke probleem bij het versterken van leren te omzeilen, hebben de onderzoekers RoboClip getest. Het is een subset van AI waarbij een machine met vallen en opstaan leert hoe hij zich moet gedragen om de beste beloning te krijgen. Uit testen bleek dat RoboClip met slechts één video- of tekstdemonstratie van een taak twee tot drie keer beter presteerde dan andere imitatieleermethoden (IL).

Toekomstig onderzoek is nodig voordat dit onderzoek zich vertaalt in een wereld waarin robots snel kunnen leren met weinig demonstraties of instructies. Maar RoboClip vertegenwoordigt wel een belangrijke stap voorwaarts in IL-onderzoek, aldus de ontwikkelaars. Op dit moment vereisen imitatieleermethoden veel demonstraties, grote datasets en substantiële menselijke supervisie voordat een robot een taak in computersimulaties onder de knie kan krijgen. Uit het RoboClip-onderzoek blijkt dat het nu van slechts één apparaat kan leren.

Out of the box

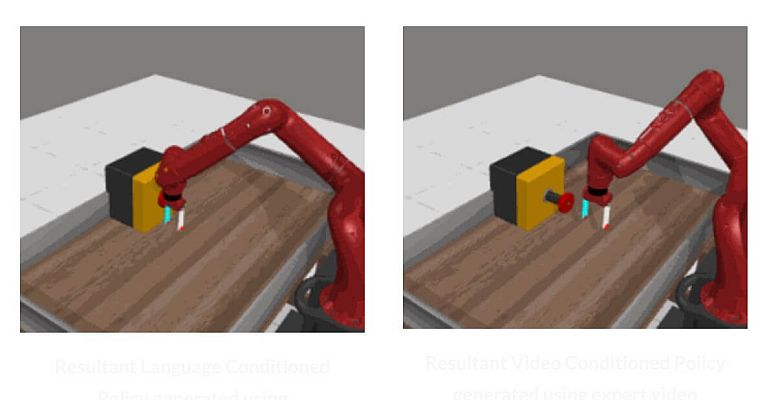

RoboClip is geïnspireerd door de vooruitgang op het gebied van generatieve AI en videotaalmodellen (VLM's), die zijn voorgetraind op grote hoeveelheden video- en tekstdemonstraties. Het nieuwe algoritme maakt gebruik van de kracht van deze VLM-inbedding om robots te trainen. Een handvol experimentele video's op de RoboClip-website tonen de effectiviteit van de methode.

In de video's drukt een robot – in computersimulaties – op een rode knop, sluit een zwarte doos en sluit een groene la. Dit doet hij nadat hij instructies heeft gekregen met een enkele videodemonstratie of een tekstuele beschrijving (bijvoorbeeld: 'Robot drukt op de rode knop).

De ontwikkelaars begonnen twee jaar geleden na te denken over huishoudelijke taken zoals het openen van deuren en kasten. Ze merkten dat ze veel data moesten verzamelen voordat ze de robot de gewenste taak konden laten uitvoeren. Dat wilden ze vermijden.

Innovatie

De belangrijkste innovatie hier is het gebruik van de VLM om simulaties van de virtuele robot die worstelt terwijl hij de taak probeert uit te voeren, kritisch te observeren. Op het moment dat de goed het goed begint te doen, zal de VLM erkennen dat vooruitgang en beloning de virtuele robot het in die richting moet blijven proberen.

De VLM kan herkennen dat de virtuele robot dichter bij succes komt wanneer de tekstuele beschrijving die door de VLM wordt geproduceerd en de robotbewegingen observeert, dichter bij komt wat de gebruiker wil. Dit soort gesloten kringloop interactie zal waarschijnlijk nog veel meer toekomstige toepassingen in andere domeinen hebben.

Foto: Viterbi School of Engineering, University of Southern California