Een nieuwe op AI gebaseerde benadering voor het besturen van vliegende robots voldoet aan de vaak tegenstrijdige doelen van veiligheid en stabiliteit.

MIT-onderzoekers ontwikkelden een machine-learningtechniek die autonoom een auto kan besturen of een vliegtuig kan besturen door een zeer moeilijk "stabiliseren-vermijden" -scenario, waarin het voertuig zijn baan moet stabiliseren om in een bepaald doelgebied te komen en te blijven, terwijl obstakels worden vermeden .

Top Gun Maverick

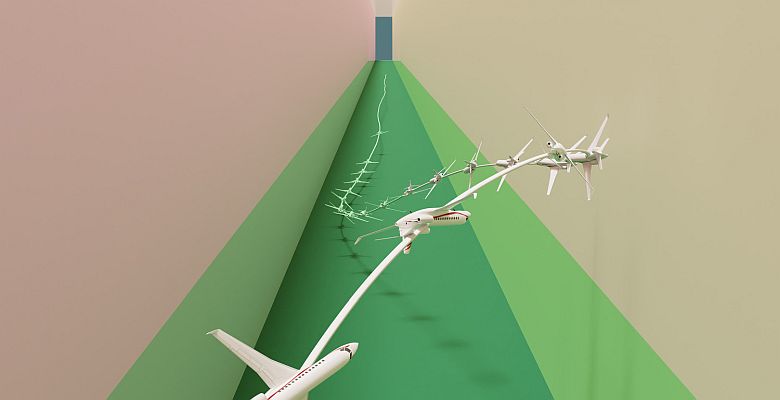

In deze film is Tom Cruise belast met het trainen van jonge piloten om een schijnbaar onmogelijke missie te volbrengen. Ze moeten hun straalvliegtuigen diep in een rotsachtige kloof laten vliegen. Ze moeten daarbij zo laag bij de grond blijven dat ze niet kunnen worden gedetecteerd door radar. Vervolgens moeten ze snel onder een extreme hoek uit de kloof klimmen en de rotswanden vermijd.

Een machine zou moeite hebben om dezelfde taak uit te voeren. Voor een autonoom vliegtuig is bijvoorbeeld het meest directe pad naar het doel in strijd met wat het moet doen om te voorkomen dat het in botsing komt met de wanden van de kloof of onopgemerkt te blijven. Veel bestaande AI-methoden kunnen dit conflict, dat bekend staat als het stabiliseren-vermijden-probleem, niet oplossen en zouden hun doel niet veilig kunnen bereiken.

Nieuwe techniek

Onderzoekers aan het Massachusetts Institute of Technology hebben een nieuwe techniek ontwikkeld die deze complexe problemen beter kan oplossen dan andere methoden. Hun machine learning benadering komt overeen met of overtreft de veiligheid van bestaande methoden. Tegelijkertijd bieden ze een hoge toename in stabiliteit, zodat het toestel zijn doelgebied bereikt en stabiel blijft. In een experiment bestuurde hun techniek effectief een gesimuleerd straalvliegtuig door een smalle gang zonder tegen de grond te botsen.

Veel onderzoekers wisten niet hoe ze met zo'n hoog-dimensionale en complexe dynamiek moesten omgaan. Veel benaderingen pakken complexe stabiliseer-vermijd-problemen aan door het systeem te vereenvoudigen. Onderzoekers kunnen het dan oplossen met rechttoe rechtaan wiskunde, maar de vereenvoudigde resultaten zijn vaak niet in overeenstemming met de werkelijke dynamiek.

Nieuwe benadering

Effectievere technieken maken gebruik van reinforcement learning, een methode waarbij een object met vallen en opstaan leert, met een beloning voor gedrag dat hem dichter bij een doel brengt. Maar er zijn hier eigenlijk twee doelen (stabiel blijven en obstakels vermijden). Het vinden van de juiste balans is lastig.

De MIT-onderzoekers splitsten het probleem op in twee stappen. Ten eerste herformuleren ze het stabiliseren-vermijden-probleem als een beperkt optimalisatieprobleem. In deze opstelling stelt het oplossen van de optimalisatie het object in staat zijn doel te bereiken en te stabiliseren. Dat betekent dat het binnen een bepaald gebied blijft. Door beperkingen toe te passen, zorgen ze ervoor dat het object obstakels vermijdt.

Voor de tweede stap herformuleren ze dat beperkte optimalisatieprobleem in een wiskundige weergave die bekend staat als de epigraafvorm. Ze losten deze op met behulp van een algoritme voor deep reinforcement learning. Met het epigraafformulier kunnen ze de moeilijkheden omzeilen waarmee andere methoden worden geconfronteerd bij het gebruik van versterkend leren.

Deep reinforcement learning is echter niet ontworpen om de epigraafvorm van een optimalisatieprobleem op te lossen. De onderzoekers konden het niet zomaar in het probleem stoppen. Ze moesten de wiskundige uitdrukkingen afleiden die voor hun systeem werken. Toen ze die nieuwe afleidingen eenmaal hadden, combineerden ze die met enkele bestaande technische trucs die door andere methoden werden gebruikt.

Experimenten

Om hun aanpak te testen, ontwierpen ze een aantal controle-experimenten met verschillende beginvoorwaarden. In sommige simulaties moet het autonome object bijvoorbeeld een doelgebied bereiken en er binnen blijven terwijl hij drastische manoeuvres uitvoert om obstakels te vermijden en ermee in botsing te komen.

In vergelijking met verschillende baselines was hun aanpak de enige die alle trajecten kon stabiliseren met behoud van veiligheid. Om hun methode nog verder te pushen, gebruikten de onderzoekers het om een gesimuleerd straalvliegtuig te besturen in een scenario dat in een Top Gun film zou passen. Het straalvliegtuig moest zich stabiliseren op een doel dichtbij de grond terwijl het een lage hoogte handhaafde en binnen een smalle vluchtcorridor bleef.

Het gesimuleerde vliegtuigmodel was als testuitdaging ontworpen door luchtverkeersleiders. Zouden onderzoekers een scenario kunnen bedenken dat hun controller niet kan vliegen? Maar dat model was zo ingewikkeld dat het moeilijk was om mee te werken, en het kon nog steeds geen complexe scenario's aan. De controller van de MIT-onderzoekers kon voorkomen dat het vliegtuig neerstortte of afsloeg terwijl het zich veel beter stabiliseerde op het doel dan andere methoden.

Vooruitzichten

In de toekomst zou deze techniek een startpunt kunnen zijn voor het ontwerpen van controllers voor dynamische robots die moeten voldoen aan veiligheids- en stabiliteitseisen, zoals bezorgdrones. Of de techniek zou kunnen worden geïmplementeerd als onderdeel van een groter systeem. Misschien wordt het algoritme alleen geactiveerd wanneer een auto slipt op een besneeuwde weg om de bestuurder te helpen veilig terug te navigeren naar een stabiel traject.

Maar het navigeren door extreme scenario's die een mens niet aan zou kunnen, is waar hun aanpak echt uitblinkt. De onderzoekers willen reinforcement learning de veiligheids- en stabiliteitsgaranties geven die nodig zijn hebben om zekerheid te bieden wanneer ze deze controllers inzetten op missiekritieke systemen. Ze zien deze studie als een veelbelovende eerste stap om dat doel te bereiken.

In de toekomst willen de onderzoekers hun techniek verbeteren, zodat deze beter rekening kan houden met onzekerheid bij het oplossen van de optimalisatie. Ze willen ook onderzoeken hoe goed het algoritme werkt wanneer het op hardware wordt ingezet, aangezien er mismatches zullen zijn tussen de dynamiek van het model en die in de echte wereld.

De wetenschappelijke publicatie vindt u hier.

Foto: MIT