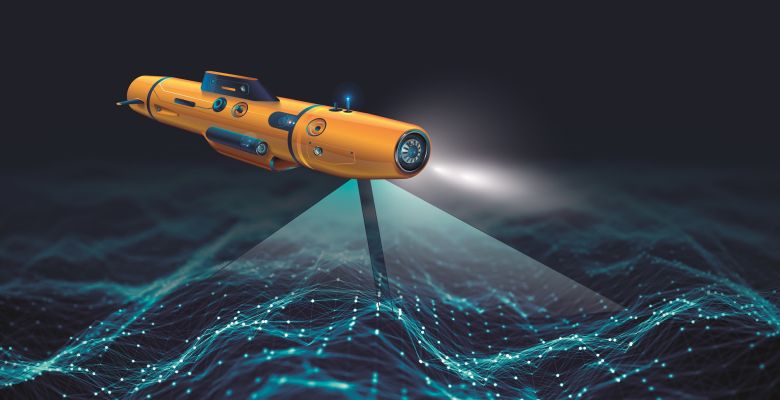

Troebel water heeft een grote impact hoe autonome robots de omgeving beleven. Hoe kunnen ze dan toch veilig en betrouwbaar opereren? Kunstmatige intelligentie helpt een handje.

Onder leiding van het Deutsches Forschungszentrum für Künstliche Intelligenz (DFKI) werkt een internationaal consortium hierteo in het nieuwe DeeperSense-project aan nieuwe technologieën. De onderzoekers combineren de sterke punten van visuele en akoestische sensoren met behulp van kunstmatige intelligentie. In drie cases uit de maritieme sector zal de perceptie van onderwatervoertuigen met robots sterk verbeterd worden.

De mogelijke toepassingen van onderwaterrobots zijn talrijk. In de praktijk ontbreekt het vaak aan functionele technologieën waarmee robots complexe omgevingen volledig kunnen waarnemen. Visuele sensoren zoals camera's geven gedetailleerde informatie over de omgeving. Maar hun prestaties zijn sterk afhankelijk van de heersende licht- en zichtomstandigheden. Akoestische sensoren voor afstandsmeting daarentegen zijn onafhankelijk van zichtbaarheid. Ze genereren ook beeldachtige gegevens, maar met een aanzienlijk lagere resolutie dan camera's. Bovendien is hun functionaliteit op korte afstand beperkt.

Op 1 januari 2021 ging daarom het DeeperSense-project (Deep-Learning for Multimodal Sensor Fusion) van start.

Intersensorisch leren

Het overkoepelende doel van het project is, de perceptie van de omgeving door servicerobots aanzienlijk te verbeteren, vooral in complexe en ongestructureerde omgevingen zoals onder water. Door gebruik te maken van kunstmatige intelligentie (AI), in het bijzonder deep learning als een datagedreven methode van machine learning, willen de onderzoekers de sterke punten van niet-visuele en visuele sensoren met elkaar combineren.

Op deze manier willen de onderzoekers het vermogen van het vaartuig om de omgeving waar te nemen via de mogelijkheden van sensoren optimaliseren. Dit moet niet alleen de prestaties en betrouwbaarheid van autonome systemen aanzienlijk verhogen, maar ook nieuwe functionaliteiten en toepassingen voor robotica openen.

Het projectconsortium brengt experts op het gebied van maritieme robotica, kunstmatige intelligentie en onderwatersensoren en eindgebruikers van drie toepassingsgebieden samen. Behalve het DFKI Robotics Innovation Center nemen de Universitat de Girona (E), de University of Haifa (IL), Kraken Robotik (D en DCN), het Technisches Hilfswerk (THW), de Israel Nature and Parks Authority en Tecnoambiente SL deel aan het project.

DeeperSense is gebaseerd op het concept van intersensorisch leren, waarbij een sensormodaliteit B leert van een sensormodaliteit A. Op deze manier kan sensor B een output leveren die vergelijkbaar is met die van sensor A, zowel wat betreft nauwkeurigheid als het type output en de interpretatie van de gegevens.

Om dit te doen observeren sensor A (bijvoorbeeld een camera) en sensor B (bijvoorbeeld een sonar) tegelijkertijd dezelfde scène. De verzamelde sonardata met lage resolutie dienen als input voor een kunstmatig neuraal netwerk, de hoge resolutie cameradata als output. Door het netwerk geleidelijk aan te passen aan de gewenste output, leert het de relaties tussen de input- en outputdata.

Het resultaat is een algoritme dat na voldoende training een camera-achtig beeld kan genereren op basis van alleen de lage resolutie sonardata. In het project wordt dit concept geïmplementeerd in drie kernalgoritmen die voldoen aan de specifieke eisen van drie use cases.

Use cases

In de eerste use case wordt een autonoom onderwatervoertuig (AUV) gebruikt om duikers te volgen die in troebel water werken. Deze taak wordt meestal uitgevoerd door een op afstand bestuurbare robot met een camera, die zijn gegevens naar een controlestation verzendt. Omdat optische sensoren onder water beperkt bruikbaar zijn, voorzien de projectpartners de onderwaterrobot ook uit met een sonarsensor. In DeeperSense willen ze hem leren camera-achtige beelden te leveren die gemakkelijk kunnen worden geïnterpreteerd door de bemanning op het controlestation.

De tweede use case betreft de verkenning van complexe en gevoelige onderwaterstructuren zoals koraalriffen door robots. Om gedetailleerde kaarten van de omgeving te kunnen maken voor een betrouwbare detectie van obstakels, steunt het project op de combinatie van visuele en akoestische sensoren. De uitdaging is om de verschillende beeldperspectieven met elkaar te vergelijken. Hiervoor moet het te ontwikkelen algoritme de data van door de ene sensor geïdentificeerde objecten kunnen herkennen in die van de andere. In de toekomst zou het voor een autonome robot mogelijk moeten zijn om door een koraalrif te navigeren in plaats van er net overheen.

In de derde use case willen de partners een AUV nauwkeurige kaarten van de zeebodem laten produceren. Deze metingen gebeuren nu door schepen en zijn kostbaar. Camera's bieden aanvullende informatie die wordt gebruikt om akoestische gegevens te verifiëren. Deze procedure is echter onpraktisch in de duisternis van diepe wateren. Om deze reden is de onderwaterrobot die in het project wordt gebruikt, bedoeld om sedimenten op de zeebodem uitsluitend op basis van akoestische gegevens te classificeren. Om dit te doen, leren de sensoren het DeeperSense-concept te gebruiken om gedetailleerde kaarten te maken van verschillende soorten zeebodem, zoals mogelijk zou zijn met camera's met goed zicht.

Algoritme-ontwikkeling

Tijdens het project genereren de partners uitgebreide trainingsdata over de drie cases. De algoritmen worden met behulp van deze gegevens getraind en getest onder reële omstandigheden, zowel in het laboratorium als in uitgebreide veldtesten - ook in binnenwateren, in de Middellandse Zee en in de Rode Zee.

Ten slotte moeten de getrainde algoritmen worden geoptimaliseerd voor het gebruik aan boord van onderwatervaartuigen om real-time uitvoering mogelijk te maken om het autonome robotgedrag te ondersteunen.

Foto: your123 - stock.adobe.com / AndSus - stock.adobe.com