Onderzoekers passen de lessen van tientallen jaren werk aan oogbeeldvorming toe op sensortechnologieën voor autonome systemen.

Lidar wordt momenteel veel toegepast bij de ontwikkelaars van zelfrijdende voertuigen. De sensoren werken in wezen net als radar, maar in plaats van radiogolven uit te zenden en naar reflecties te zoeken, gebruiken ze korte lichtpulsen van lasers. Maar traditionele time-of-flight LiDAR heeft nadelen die het moeilijk maken om de techniek in veel 3D-visietoepassingen te gebruiken.

Omdat het detectie van zwakke gereflecteerde lichtsignalen vereist, kunnen andere LiDAR-systemen of omgevingszonlicht de detector 'verblinden'. Lidar heeft ook een beperkte diepteresolutie en het kan (te) lang duren om een groot gebied zoals een snelweg of fabrieksvloer te scannen.

FMCW LiDAR

Om deze uitdagingen aan te gaan, wenden onderzoekers van Duke University in Durham (North Carolina) zich tot frequency modulated continuous wave (FMCW) Lidar. Deze technologie deelt hetzelfde werkingsprincipe als optische coherentietomografie (OCT), dat de biomedische technologie sinds het begin van de jaren negentig heeft ontwikkeld.

Maar dertig jaar geleden wist niemand iets van autonome auto's of robots, dus de technologie richtte zich op weefselbeeldvorming. Om het bruikbaar te maken voor andere opkomende gebieden moeten de extreem hoge resolutiemogelijkheden worden ingeruild voor meer afstand en snelheid.

Met een paar trucjes uit hun OCT-onderzoek hebben de wetenschappers geleerd hoe ze 25 keer de eerdere FMCW Lidar-gegevensdoorvoer kunnen verbeteren, terwijl ze toch een nauwkeurigheid van submillimeter bereiken. De technologie zendt een laserstraal uit die voortdurend verschuift tussen verschillende frequenties.

Frequenties en roosters

Wanneer de detector licht verzamelt om zijn reflectietijd te meten, kan hij onderscheid maken tussen het specifieke frequentiepatroon en elke andere lichtbron. Hierdoor hij in allerlei lichtomstandigheden met hoge snelheid werken. De sensor meet elke faseverschuiving tegen ongehinderde stralen, wat een veel nauwkeurigere manier is om afstand te bepalen dan de huidige LiDAR-systemen.

In plaats van roterende spiegels om de laser over de omgeving gebruiken de Duke onderzoekers een diffractierooster dat werkt als een prisma. Het breekt de laser op in een regenboog van frequenties die zich verspreiden terwijl ze weg van de bron reizen. Omdat de originele laser nog steeds snel door een reeks frequenties veegt, vertaalt dit zich in het veel sneller scanner van de Lidar-straal dan een mechanische spiegel kan draaien. Hierdoor kan het systeem snel een groot gebied bestrijken zonder veel diepte of locatienauwkeurigheid te verliezen.

3D-vision systemen voor robots hoeven alleen de oppervlakken van objecten op menselijke schaal te lokaliseren. Om dit te bereiken, vernauwden de onderzoekers het frequentiebereik dat door OCT wordt gebruikt. Ze zochten naar het pieksignaal dat werd gegenereerd door de oppervlakken van objecten. Dit kost een beetje resolutie, maar geeft een veel groter beeldbereik en snelheid dan traditionele LiDAR.

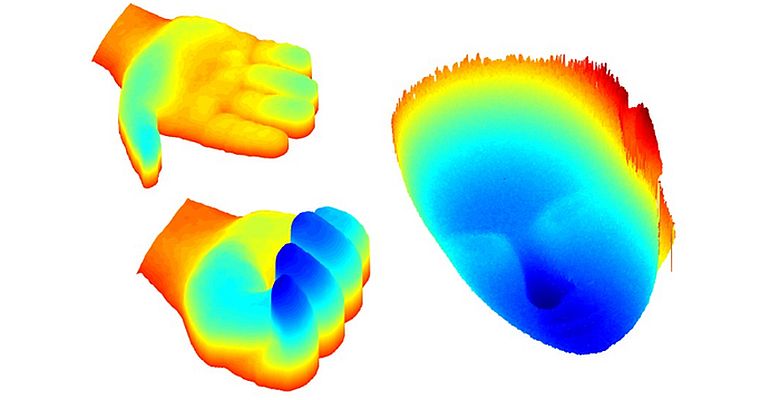

De resultaten laten zien dat de aanpak snel en nauwkeurig genoeg is om de details van bewegende menselijke lichaamsdelen – zoals een knikkend hoofd of een gebalde hand – real-time vast te leggen. De onderzoekers willen een nieuwe generatie op Lidar gebaseerde 3D-camera's ontwikkelen die snel en capabel genoeg zijn om 3D-visie in allerlei producten te integreren.

Foto: Ruobing Qian, Duke University