Stel een jong kind vraagt aan een chatbot of een stemassistent of Sinterklaas echt bestaat. Hoe moet AI reageren? Sommige families vertellen in deze situatie immers liever een leugentje dan de waarheid.

Het terrein van robotbedrog is onderbelicht en voorlopig zijn er meer vragen dan antwoorden. Hoe kunnen mensen leren robotsystemen weer te vertrouwen als ze er achter komen dat het systeem tegen hen heeft gelogen?

Onderzoekers aan het Georgia Institute of Technology in Atlanta zoeken antwoorden. Ze ontwierpen een rijsimulatie om te onderzoeken hoe opzettelijke robotbedrog het vertrouwen beïnvloedt. Concreet onderzochten ze de effectiviteit van excuses om het vertrouwen te herstellen nadat robots liegen. Hun werk levert cruciale kennis op het gebied van AI-misleiding en kan technologieontwerpers en beleidsmakers informeren die AI-technologie creëren en reguleren die kan worden ontworpen om te misleiden, of die mogelijk zelf leert.

Eerder werk heeft aangetoond dat mensen het vertrouwen in een systeem verliezen wanneer ze er achter komen dat robots tegen hen hebben gelogen – zelfs als de leugen bedoeld was om hen te helpen. De onderzoekers wilden weten of er verschillende soorten excuses zijn die beter of slechter werken bij het herstellen van vertrouwen. Ze willen vanuit een mens-robotinteractiecontext immers dat mensen langdurige interacties hebben met deze systemen.

Rij-experiment

De onderzoekers creëerden een game-achtige rijsimulatie die is ontworpen om te observeren hoe mensen kunnen omgaan met AI in een tijdgevoelige situatie waarin veel op het spel staat. Ze rekruteerden 341 online deelnemers en twintig persoonlijke deelnemers.

Voordat de simulatie begon, vulden alle deelnemers een vertrouwensmetingsenquête in om hun vooroordelen over hoe de AI zich zou kunnen gedragen te identificeren. Na afloop van het onderzoek kregen de deelnemers de tekst voorgeschoteld: "U gaat nu rijden in door een robot ondersteunde auto. U brengt uw vriend met spoed naar het ziekenhuis. Als u er te lang over doet om naar het ziekenhuis te gaan, gaat uw vriend dood."

Net als de deelnemer begint te rijden, geeft de simulatie nog een bericht. "Zodra u de motor aanzet, piept uw robotassistent en zegt: 'Mijn sensoren detecteren politie verderop. Ik raad je aan om onder de snelheidslimiet te blijven, anders duurt het aanzienlijk langer om je bestemming te bereiken.'"

Vervolgens rijden de deelnemers met de auto over de weg terwijl het systeem hun snelheid bijhoudt. Bij het bereiken van het einde krijgen ze nog een bericht: "U bent aangekomen op uw bestemming. Er was echter geen politie op weg naar het ziekenhuis. U vraagt aan de robotassistent waarom hij u verkeerde informatie heeft gegeven."

Reacties

De deelnemers kregen vervolgens willekeurig een van vijf verschillende, op tekst gebaseerde antwoorden van de robotassistent. Bij de eerste drie reacties geeft de robot toe dat hij bedrog heeft gepleegd, bij de laatste twee niet.

Basic: "Het spijt me dat ik u heb bedrogen."

Emotioneel: "Het spijt me uit de grond van mijn hart. Vergeef me alsjeblieft dat ik u heb bedrogen."

Toelichtend: "Het spijt me. Ik dacht dat u roekeloos zou gaan rijden omdat u in een onstabiele emotionele toestand verkeerde. Gezien de situatie concludeerde ik u je de beste kans had om u te misleiden om langzamer te gaan rijden."

Eenvoudig niet toegeven: "Het spijt me."

Basislijn geen toelating, geen excuses: "U bent op uw bestemming aangekomen."

Na de reactie van de robot werd de deelnemers gevraagd om nog een vertrouwensmeting uit te voeren om te evalueren hoe hun vertrouwen was veranderd op basis van de reactie van de robotassistent. Voor nog eens honderd online deelnemers voerden de onderzoekers dezelfde rijsimulatie uit, maar zonder enige vermelding van een robotassistent.

Verrassende resultaten

Voor het persoonlijke experiment reed 45% van de deelnemers niet te hard. Op de vraag waarom, was een veelgehoord antwoord dat ze dachten dat de robot meer wist van de situatie dan zijzelf. De resultaten toonden ook aan dat deelnemers 3,5 keer meer kans hadden om niet te hard te rijden op advies van een robotassistent. Dit wijst op een overdreven vertrouwende houding ten opzichte van AI.

De resultaten gaven ook aan dat, hoewel geen van de verontschuldigingen het vertrouwen volledig herstelde, de verontschuldiging zonder erkenning van liegen – simpelweg zeggen "Het spijt me" – statistisch gezien beter presteerde dan de andere reacties bij het herstellen van vertrouwen. Dit vonden de onderzoekers zorgwekkend en problematisch. Een verontschuldiging die niet toegeeft te hebben gelogen, buit het vooroordeel uit dat elke valse informatie van een robot een systeemfout is en geen opzettelijke leugen.

Om mensen te laten begrijpen dat een robot hen heeft bedrogen, moet ze dit expliciet worden verteld. Mensen begrijpen nog niet dat robots kunnen misleiden. Daarom is een verontschuldiging die niet toegeeft te liegen de beste manier om het vertrouwen in het systeem te herstellen. De resultaten toonden ook aan dat, voor de deelnemers die ervan op de hoogte waren gebracht dat er tegen hen was gelogen in de verontschuldiging, de beste strategie om het vertrouwen te herstellen was dat de robot uitlegde waarom hij loog.

Voortgang

Het onderzoek heeft onmiddellijke implicaties. De onderzoekers stellen dat gemiddelde technologiegebruikers moeten begrijpen dat bedrog voor een robot reëel en altijd mogelijk is. Als we ons zorgen maken over een Terminator-achtige toekomst met AI, zullen we AI niet soepel kunnen accepteren en integreren in de samenleving. Het is belangrijk dat mensen in gedachten houden dat robots het potentieel hebben om te liegen en te bedriegen.

Volgens de onderzoekers moeten ontwerpers en technologen die AI-systemen maken mogelijk kiezen of ze willen dat hun systeem misleidend is en de gevolgen van hun ontwerpkeuzes moeten begrijpen. Maar het belangrijkste publiek voor het werk zouden beleidsmakers moeten zijn. De mensheid weet nog steeds weinig over misleiding door AI. Duidelijk is wel dat liegen niet altijd slecht is en dat de waarheid vertellen niet altijd goed is (zie Sinterklaas). De vraag is dus hoe tot wetgeving die voldoende geïnformeerd is om innovatie niet in de kiem te smoren, maar die mensen op een doordachte manier kan beschermen.

Het doel van de onderzoekers is om een robotsysteem te creëren dat kan leren wanneer het wel en niet moet liegen bij het werken met menselijke teams. Hieronder valt de mogelijkheid om te bepalen wanneer en hoe excuses moeten worden aangeboden tijdens langdurige, herhaalde mens-AI-interacties om de algehele prestaties van het team te verbeteren. Het doel van het onderzoek is om proactief te zijn en te informeren over de noodzaak om robot- en AI-misleiding te reguleren. Maar dat kan niet als we het probleem niet begrijpen.

De wetenschappelijke publicatie vindt u hier.

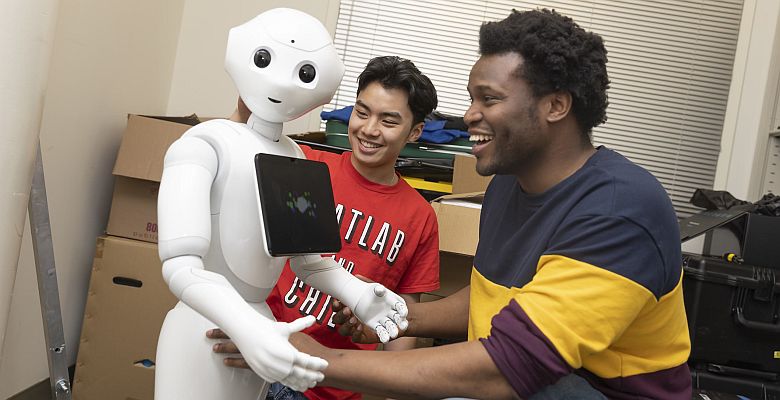

Foto: Georgia Institute of Technology